Специалисты из лаборатории исследований искусственного интеллекта Tinkoff Research создали эффективный алгоритм для обучения и адаптации ИИ. Новый метод назван ReBRAC (Revisited Behavior Regularized Actor Critic). Он представляет собой пересмотренный актор‑критик с контролируемым поведением. По словам создателей, алгоритм обучает ИИ в четыре раза быстрее и на 40% качественнее существующих мировых аналогов в области обучения с подкреплением (Reinforcement Learning, RL), адаптируя его к новым условиям на ходу. Об этом информационной службе Хабра рассказали в пресс‑службе «Тинькофф».Визуализация качества альтернативных подходов и алгоритма ReBRAC. По горизонтальной оси — качество алгоритма относительно «эксперта» (служит эталоном для обучения ИИ‑агентов), где 100 — это уровень эксперта. По вертикальной оси — процент испытаний, в которых удалось превзойти выбранную отсечку качества. Чем выше линия, тем лучше. Метод, предложенный Tinkoff Research, стал первым превзошедшим эксперта более чем в половине испытаний

Результаты исследования были представлены на научной конференции в области ИИ по машинному обучению и нейровычислениям NeurIPS (The Conference and Workshop on Neural Information Processing Systems). В этом году конференция проходила в Новом Орлеане (США) с 10 по 16 декабря 2023 года.

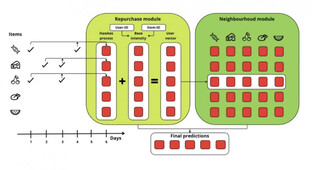

Специалисты Tinkoff Research идентифицировали четыре компонента, представленные в алгоритмах последних лет. Они считались второстепенными и не подвергались детальному анализу. Список изучаемых компонентов:

Глубина нейронных сетей. Параметр увеличения глубины сети помогает ей лучше понимать сложные закономерности в данных;

Регуляризация актора и критика. В ИИ‑агентах есть два компонента: «актор», предпринимающий действия, и «критик», оценивающий эти действия. Учёные использовали совместную регуляризацию обоих компонентов, чтобы актор избегал нежелательных действий, а критик более эффективно оценивал их;

Увеличение эффективного горизонта планирования. Этот параметр позволяет модели балансировать между краткосрочными и долгосрочными аспектами задачи и улучшает ее способность принимать решения;

Использование нормализации слоёв (LayerNorm). Это параметр стабилизирует процесс обучения нейронных сетей.

Tinkoff Research интегрировала эти компоненты в алгоритм‑предшественник BRAC (Behavior Regularized Actor Critic — актор‑критик с контролируемым поведением) 2019 года и провели исследование, поочерёдно варьируя каждый из них. Правильная совокупность этих компонентов дала этому подходу высокую производительность среди существующих аналогов.

Тестирование на робототехнических симуляторах показало, что алгоритм обучает ИИ в четыре раза быстрее и на 40% качественнее всех существующих в офлайн‑бенчмарках. Ранее лидерство принадлежало алгоритму SAC‑RND, также созданному учёными из Tinkoff Research.Визуализация вариантов тестирования алгоритма: поиск цели в лабиринте (Ant), скорость бега (Halfcheetah, Hopper, Walker2d), задачи для робокистей — правильно держать ручку (Pen), открыть дверь, забить гвоздь, переместить объект

Как утверждают специалисты Tinkoff Research, ReBRAC эффективнее существующих аналогов решает проблему дообучения искусственного интеллекта, который обычно медленно адаптируется к новым условиям. Например, если робот, изначально обученный передвигаться по траве, упадет, переместившись на лед, то ReBRAC позволит роботу лучше учиться на ходу и адаптироваться.

Источник новости: habr.com