Apple выпустила модель машинного обучения MGIE (MLLM-Guided Image Editing), предназначенную для редактирования изображений по текстовому описанию. Нейросеть разрабатывали совместно с исследователями Калифорнийского университета в Санта-Барбаре.

MGIE — мультимодальная модель, которая умеет работать с несколькими типами данных. К примеру, нейросеть может распознавать команды на естественном языке, образы на исходной фотографии и генерировать новые объекты с помощью диффузионной модели. Такой подход позволяет объединить несколько задач в одной нейросети.

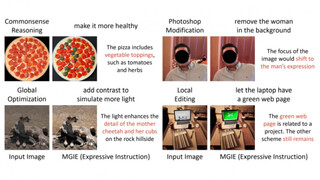

Модель MGIE получает на вход изображение и текстовое описание изменений, которые необходимо внести. После этого нейросеть перерисовывает изображение, учитывая инструкции пользователя. К примеру, можно попросить добавить больше зелени на фотографию, удалить некоторые объекты или дорисовать новые.

На портале arxiv.org инженеры Apple опубликовали подробности исследования, лежащего в основе проекта. Код и веса доступны в открытом GitHub-репозитории. На Hugging Face энтузиасты развернули тестовое веб-приложение на базе MGIE.

Источник новости: habr.com