Microsoft выпустила набор инструментов Python Risk Identification Toolkit для генеративного искусственного интеллекта (PyRIT). Этот инструмент использует команда AI Red Team для проверки рисков в системах искусственного интеллекта, включая Copilot.

PyRIT может генерировать тысячи вредоносных запросов для тестирования модели искусственного интеллекта нового поколения и оценивать её реакцию.

В 2023 году Microsoft объединила более 60 высокоценных систем искусственного интеллекта поколения, благодаря чему стало ясно, что этот процесс сильно отличается от классической разработки софта или ИИ. Так, помимо обычных рисков безопасности процесс должен гарантировать, что модель не генерирует вредоносный контент или дезинформацию.

Кроме того, модели искусственного интеллекта сильно различаются по архитектуре, и на основе одних и тех же обучающих данных можно получить разные результаты. Это затрудняет поиск единого оптимизированного процесса, подходящего для всех моделей.

Ручная проверка всех рисков оказывается трудоёмким и медленным процессом. Microsoft утверждает, что автоматизация поможет командам выявлять рискованные области, требующие большего внимания.

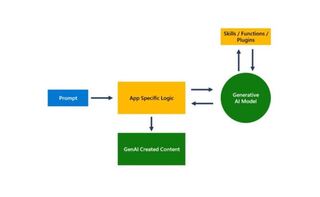

Набор инструментов отправляет вредоносный запрос в генеративную систему искусственного интеллекта, а при получении ответа агент выставляет модели оценку. Она используется для отправки нового запроса.

PyRIT поддерживает различные формулировки целей генеративного ИИ, а также текстовый ввод и может быть расширен и для других модальностей. Набор предлагает интеграцию с моделями из службы Microsoft Azure OpenAI и Hugging Face.

Используя наборы данных, специалисты по безопасности кодируют то, что они хотят проверить в системе. Это может быть либо статический набор вредоносных запросов, либо динамический шаблон приглашений. Шаблоны подсказок позволяют автоматически кодировать несколько категорий. Встроенный механизм предлагает два варианта оценки результатов работы системы: с использованием классического классификатора машинного обучения или использованием конечной точки LLM. Можно также напрямую использовать фильтры содержимого Azure AI в качестве API.

PyRIT поддерживает два стиля стратегии атаки: однооборотный с отправкой в систему комбинации запросов на джейлбрейк или иных вредоносных запросов с оценкой ответов; многоходовую стратегию, при которой инструмент отправляет в систему ИИ комбинацию запросов на джейлбрейк и вредоносы, оценивает ответы, а затем отвечает модели на основе оценки. Это позволяет воспроизводить более реалистичные сценарии поведения злоумышленников и более продвинутые стратегии атаки.

PyRIT позволяет сохранять промежуточные взаимодействия ввода и вывода для их более глубокого анализа.

Microsoft приводит пример того, как PyRIT помогла команде AI Red Team. «В системе Copilot мы смогли выбрать категорию ущерба, сгенерировать несколько тысяч вредоносных запросов и использовать систему для оценки результатов модели за считанные часы вместо недель», — отмечают в компании.

Набор инструментов доступен всем желающим и включает список демонстрационных версий, которые помогут ознакомиться с его работой. Microsoft также проводит вебинары по PyRIT.

Ранее OpenAI запустила программу багбаунти в своих ИИ-сервисах с вознаграждением до $20 тыс.

Источник новости: habr.com