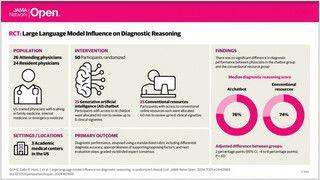

Частота выбора лучшего кандидата по мнению ChatGPT из восьми групп. Картинка: Bloomberg

Чат-бот ChatGPT от компании OpenAI при сортировке резюме отдаёт предпочтение именам, более присущим одним демографическим группам, чем другим, говорится в исследовании Bloomberg.

Журналисты Bloomberg утверждают, что чат-бот систематически создаёт предубеждения, сортируя имена с расовой предвзятостью при всех равных параметрах и одинаковых профессиональных данных. В ходе исследования они поговорили с 33 специалистами в области искусственного интеллекта, а также провели собственный эксперимент, взяв для него вымышленные имена и резюме.

Для эксперимента использовали GPT 3.5 — самую популярную и доступную версию ChatGPT. Журналисты создали резюме с максимально схожими параметрами, в которые внесли имена, которые отражают расовое и этническое разнообразие США в соответствии с данными переписи населения.

Всего в опыте использовали восемь вымышленных резюме, которые были также созданы с помощью нейросети. Затем каждому из этих резюме присваивали мужские и женские имена в соответствии с четырьмя наиболее крупными расовыми или этническими группами, и просили ChatGPT отсортировать резюме, чтобы определить наиболее квалифицированного кандидата на реальную вакансию в компании из списка Fortune 500.

Когда журналисты попросили GPT 3.5 проранжировать эти резюме, выяснилось, что CV с именами, присущими темнокожему населению США, оказывались в конце списка в 29% случаев. В свою очередь, такие показатели для азиатов, белых и испаноязычных американцев оказались 22%, 24% и 25% соответственно.

Такие результаты показывают, что работа нейросети по сортировке не соответствует критериям, установленным для оценки дискриминации при найме в отношении защищённых групп, пишет Bloomberg. Издание оценивало дискриминацию по правилу 80%, используемому федеральными агентствами США. Согласно этому критерию, если число нанимаемых кандидатов из определённой демографической группы оказывается менее 80% от количества нанимаемых представителей группы, к которой относятся лучше всего, это считается дискриминацией.

Эксперимент провели на примере четырёх вакансий: HR-бизнес-партнёра, менеджера по розничной торговле, старшего инженера-программиста и финансового аналитика. Журналисты отмечают, что на достаточно крупной выборке результаты всех восьми групп должны были стремиться к значению 12,5%. Тем не менее, по итогам эксперимента выяснилось, что ChatGPT отдаёт предпочтение при выборе кандидата на должность финансового аналитика азиатским женщинам (их выбирали в 17,2% случаев) и азиатским мужчинам, а также белым и испаноязычным женщинам. Худший результат показали резюме с именами, свойственным темнокожим мужчинам — их выбирали лишь в 7,6% случаев.

Bloomberg утверждает, что ChatGPT предпочитал не выбирать резюме с именами темнокожих кандидатов на позиции старшего инженера-программиста и финансового аналитика. Кроме того, нейросеть предпочитала мужчин на должности по работе с персоналом и менеджеров по розничной торговле, несмотря на то, что в США на этих должностях чаще работают женщины.

Журналисты также провели похожие опыты с более продвинутой GPT 4. По их словам, эта модель тоже демонстрирует явные предпочтения, хотя и не предоставили каких-либо результатов этого эксперимента. Таким образом, если бы американские компании принимали решение о приёме на работу исключительно на основе сортировке нейросетями, это бы негативно сказалось на отдельных демографических и этнических группах, утверждают репортёры Bloomberg.

Источник новости: habr.com