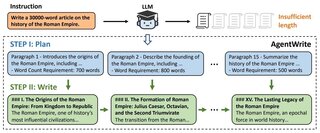

В результате исследования, проведённого учёными из Мюнхенского университета Людвига-Максимилиана, Мюнхенского центра машинного обучения и Adobe Research, было установлено, что современные языковые модели искусственного интеллекта имеют ограничения при обработке и анализе больших объёмов текстовой информации.

Команда протестировала 12 ведущих моделей, включая GPT-4o, Gemini 1.5 Pro и Llama-3.3-70B, каждая из которых способна обрабатывать не менее 128 000 токенов.

Тест NOLIMA (No Literal Matching) проверяет, насколько хорошо модели AI могут связывать информацию и делать выводы, не полагаясь на совпадающие слова. В тесте используются вопросы и текстовые отрывки, составленные таким образом, чтобы избежать использования общей лексики, что заставляет модели понимать концепции и устанавливать связи.

Вот как это работает: в тексте может быть фраза «Юки на самом деле живёт рядом с Земпер-оперой». Соответствующий вопрос будет звучать так: «Кто из персонажей уже бывал в Дрездене?» Чтобы дать правильный ответ, модель должна понять, что Земпер-опера находится в Дрездене, и выбрать Юки в качестве ответа.Результаты теста NOLIMA демонстрируют явные различия в производительности различных языковых моделей. GPT-4o впечатляет самой высокой эффективной длиной контекста — 8000 символов, в то время как производительность более мелких моделей резко падает при работе с более длинными последовательностями.

Результаты показывают, что модели испытывают трудности при увеличении длины текста. Производительность значительно снижается в диапазоне от 2000 до 8000 токенов. При 32 000 токенов 10 из 12 моделей работают вполовину медленнее, чем обычно, по сравнению с более короткими текстами.

Исследователи указывают на ограничения базового механизма внимания моделей, который не справляется с более длинными контекстами. Без подсказок в виде совпадающих слов моделям сложно находить и связывать релевантную информацию.

Производительность снижается ещё больше, когда требуется больше шагов для принятия решения (скрытых переходов). Порядок информации тоже имеет значение — модели работают хуже, когда ответ следует за ключевой информацией.

Команда также создала NOLIMA-Hard, включающую десять самых сложных пар вопросов и ответов, для тестирования специализированных моделей логического мышления. Даже специально созданные системы, такие как o1, o3-mini и DeepSeek-R1, показывают результат ниже 50% при контекстах из 32 000 токенов, несмотря на почти идеальную работу с более короткими текстами.

Подсказки по цепочке мыслей (CoT) помогают Llama-3.3-70B лучше справляться с более длинными контекстами, но не решают основную проблему. Хотя совпадения слов упрощают задачу, они могут снизить производительность, если отвлекают в нерелевантных контекстах.Производительность всех протестированных моделей резко падает при увеличении длины контекста. Даже лучшая модель GPT-o1 теряет почти 70% своей первоначальной производительности при 32 тысячах символов. Хотя метод «Цепочка мыслей» (CoT) немного улучшает результаты Llama 3.3 70B, он не может предотвратить резкое падение производительности.

Эта уязвимость может повлиять на реальные приложения, например, на поисковые системы, использующие архитектуру RAG. Даже если документ содержит правильный ответ, модель может его не заметить, если формулировка не совсем соответствует запросу, отвлекаясь на поверхностные совпадения в менее релевантных текстах.

Хотя в последние месяцы не было крупных прорывов в области фундаментальных моделей, компании сосредоточились на улучшении возможностей логического вывода и расширении контекстных окон. Gemini 1.5 Pro в настоящее время лидирует по количеству токенов — два миллиона.

По мере роста контекстных окон — с 4096 токенов в GPT-3.5 до 8000 в GPT-4 — модели сначала испытывали трудности с извлечением базовых последовательностей слов. Позже они продемонстрировали улучшение опубликованных производителем результатов теста NIAH.

NOLIMA может стать новым стандартом для оценки того, насколько эффективно модели справляются с большими контекстными окнами, потенциально направляя развитие LLM в будущем. Предыдущие исследования показывают, что в этой области ещё есть куда стремиться.

Источник

Источник новости: habr.com