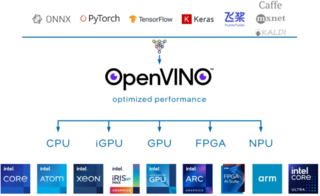

6 марта 2024 года Intel выпустила набор инструментов OpenVINO 2024.0 для нейронных сетей с использованием встроенной поддержки анализа производительности (бенчмарк), анализа пропускной способности и задержки для различных моделей, который позволяет проводить оптимизации и развёртывания ИИ-систем на различном оборудовании. Исходный код проекта выложен на GitHub под лицензией Apache License 2.0.

Проект OpenVINO предназначен для тестирования работы ИИ не только на процессорах x86_64, но также на процессорах ARM и других архитектурах, интегрированной и дискретной графике Intel и многом другом оборудовании. Проект поддерживает с помощью плагина возможность использования нейронной обработки блока NPU на новых процессорах Intel Core Ultra Meteor Lake.

В OpenVINO 2024.0 добавлены новые функции для работы с генеративном ИИ (GenAI) включая работу из коробки с моделями энкодера предложений TensorFlow, поддержкой Mixture of Experts (MoE) и проверенными моделями Mistral. Проект получил поддержку API javascript для беспрепятственного доступа к API OpenVINO.

OpenVINO 2024.0 также обеспечивает улучшенное качество сжатия веса INT4 для LLM (БЯМ - больших языковых моделей), повышенную производительность LLM на процессорах Intel, упрощённую оптимизацию и преобразование моделей Hugging Face, а также получил другие улучшения интеграции с Hugging Face.

Разработчики пояснили, что OpenVINO 2024.0 также обеспечивает лучшую производительность на процессорах ARM и получил различные улучшения в коде своей платформы.

В OpenVINO 2024.0 прекращена поддержка предыдущего решения Gaussian and Neural Accelerator (Intel GNA) от Intel. Проект теперь фокусируется на NPU в процессорах Meteor Lake и новее. Плагин Intel NPU для OpenVINO теперь распространяется как часть основного пакета OpenVINO на PyPi.

Источник новости: habr.com