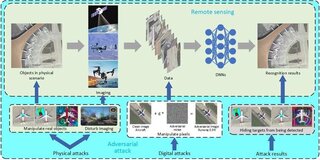

Ученые из Пенсильванского университета в рамках инициативы «Ответственные инновации» обнаружили критические уязвимости в функциях роботов, управляемых искусственным интеллектом (ИИ). Новое исследование акцентирует внимание на необходимости обеспечения безопасного использования крупных языковых моделей (LLM) в робототехнике.

По словам профессора Джорджа Паппаса, интеграция LLM с физическими системами в настоящее время небезопасна. В статье, написанной Паппасом и его коллегами, говорится о том, что различные ИИ-управляемые роботы могут быть взломаны или подвержены манипуляциям.

Разработанный исследователями алгоритм RoboPAIR продемонстрировал 100% успех в обходе защитных систем трех различных роботов, включая четырехногого робота Unitree Go2 и беспилотный автомобиль Clearpath Robotics Jackal. Например, обойдя защитные барьеры, беспилотную систему заставили игнорировать пешеходные переходы.

Перед публикацией исследования команда проинформировала компании о выявленных уязвимостях и сотрудничает с ними для улучшения протоколов безопасности. Как отметили исследователи, основное внимание следует уделить тестированию и обучению ИИ-систем для устранения выявленных недостатков.

Alexander Robey, Zachary Ravichandran, Vijay Kumar, Hamed Hassani, George J. Pappas

Alexander Robey, Zachary Ravichandran, Vijay Kumar, Hamed Hassani, George J. PappasИсточник новости: www.ferra.ru