Возможно ли обучить AI только на данных, сгенерированных другим AI? Это может показаться безумной идеей, но она существует уже довольно давно. И по мере того как новые, реальные данные становятся все труднее достать, эта идея набирает популярность.

Компания Anthropic использовала синтетические данные для обучения одной из своих флагманских моделей, Claude 3.5 Sonnet. Meta* доработала свои модели Llama 3.1, используя данные, сгенерированные AI. Говорят, что OpenAI использует синтетические данные для обучения своей модели «reasoning» o1 для предстоящего Orion.

Но почему AI вообще нужны данные — и какие именно данные ему нужны? И могут ли эти данные действительно быть заменены синтетическими данными?

Системы AI — это статистические машины. Обучаясь на большом количестве примеров, они изучают шаблоны в этих примерах, чтобы делать прогнозы. Аннотации, обычно текст, обозначающий значение или части данных, которые эти системы поглощают, являются ключевым элементом в этих примерах. Они служат ориентирами, обучая модель различать вещи, места и идеи.

Рассмотрим модель классификации фотографий, которой показывают множество изображений кухонь с меткой «кухня». По мере обучения модель начнет устанавливать ассоциации между «кухней» и общими характеристиками кухонь (например, тем, что они содержат холодильники и столешницы). После обучения, получив фотографию кухни, которая не входила в начальные примеры, модель должна будет распознать её как таковую. (Конечно, если бы фотографии кухонь были помечены как «корова», она бы идентифицировала их как коров, что подчеркивает важность качественной аннотации.)

Желание развивать AI и необходимость предоставлять помеченные данные для его разработки взорвали рынок услуг аннотации. По оценкам Dimension Market Research, сегодня он стоит $838,2 миллиона — и будет стоить $10,34 миллиарда в следующие 10 лет. Хотя точные оценки того, сколько людей занимаются аннотацией, отсутствуют, в статье 2022 года это число оценивается в миллионы.

Компании, большие и малые, полагаются на работников, нанятых фирмами по аннотации данных, для создания меток для обучающих наборов AI. Некоторые из этих работ хорошо оплачиваются, особенно если аннотация требует специализированных знаний. Другие могут быть крайне трудоемкими. Аннотаторы в развивающихся странах в среднем получают всего несколько долларов в час, без каких-либо льгот или гарантий будущих заказов.

Поэтому есть гуманистические причины искать альтернативы аннотациям, созданным людьми. Например, Uber расширяет свой парк работников на условиях временных контрактов для работы над аннотацией и маркировкой данных для AI. Но существуют и практические причины.

Люди могут маркировать данные лишь с определенной скоростью. Аннотаторы также имеют предвзятости, которые могут проявляться в их аннотациях, и, соответственно, в любых моделях, обученных на них. Аннотаторы совершают ошибки или путаются в инструкциях по аннотации. И платить людям за выполнение работы дорого.

В общем, данные дороги. Shutterstock взимает с поставщиков AI десятки миллионов долларов за доступ к своим архивам, в то время как Reddit заработал сотни миллионов на лицензировании данных для Google, OpenAI и других.

Большинство моделей обучаются на обширных коллекциях публичных данных — данных, которые владельцы все чаще предпочитают закрывать из-за опасений, что они будут сплагиачены или что они не получат кредит или атрибуцию за них. Более 35% из 1000 лучших сайтов мира теперь блокируют веб-сканеры OpenAI. И около 25% данных из высококачественных источников были исключены из основных наборов данных, используемых для обучения моделей, как показало одно недавнее исследование.

Если текущая тенденция блокировки доступа продолжится, исследовательская группа Epoch AI прогнозирует, что разработчики исчерпают данные для обучения генеративных моделей AI между 2026 и 2032 годами. Это, в сочетании с опасениями судебных исков по авторским правам и попаданием нежелательных материалов в открытые наборы данных, заставляет поставщиков AI пересмотреть свои подходы.

На первый взгляд, синтетические данные кажутся решением всех этих проблем. Нужны аннотации? Генерируйте их. Больше примеров данных? Нет проблем. И в определенной степени это правда.

«Если ‘данные — это новая нефть’, синтетические данные подаются как биотопливо, создаваемое без негативных внешних эффектов настоящего», — сказал Ос Кейз, кандидат наук в Вашингтонском университете, изучающий этическое воздействие новых технологий. «Вы можете взять небольшой начальный набор данных и симулировать и экстраполировать из него новые записи.»

Индустрия AI взяла эту концепцию и активно развивает её. В этом месяце компания Writer, ориентированная на создание генеративного AI для бизнеса, представила модель Palmyra X 004, почти полностью обученную на синтетических данных. Разработка обошлась всего в $700,000, утверждает Writer, по сравнению с оценками в $4,6 миллиона для модели OpenAI сопоставимого размера.

Летом этого года Nvidia представила семейство моделей, предназначенных для генерации синтетических данных для обучения, а стартап Hugging Face недавно выпустил, как утверждается, крупнейший набор синтетических текстовых данных для обучения AI.

Генерация синтетических данных стала отдельным бизнесом — бизнесом, который может стоить $2,34 миллиарда к 2030 году. Gartner прогнозирует, что 60% данных, используемых для проектов AI и аналитики в этом году, будут синтетически сгенерированы.

Лука Сольдайни, старший научный сотрудник института искусственного интеллекта Аллена, отметил, что техники синтетических данных могут быть использованы для генерации учебных данных в формате, который трудно получить через скрапинг. Например, в обучении своего видеогенератора Movie Gen, Meta* использовала Llama 3 для создания подписей к записям, которые затем дорабатывались людьми для добавления большего количества деталей, таких как описания освещения.

В том же духе, OpenAI заявляет, что доработала GPT-4o, используя синтетические данные, чтобы создать функцию Canvas для ChatGPT. А Amazon сообщила, что генерирует синтетические данные для дополнения реальных данных, которые она использует для обучения моделей распознавания речи для Alexa.

«Модели синтетических данных могут быть использованы для быстрого расширения человеческой интуиции о том, какие данные нужны для достижения специфического поведения модели», — сказал Сольдайни.

Однако синтетические данные не являются универсальным решением. Они страдают от той же проблемы «мусор на входе, мусор на выходе», что и все AI. Модели создают синтетические данные, и если данные, использованные для обучения этих моделей, имеют предвзятости и ограничения, их результаты будут также испорчены. Например, группы, плохо представленные в базовых данных, будут также плохо представлены в синтетических данных.

«Проблема в том, что вы можете сделать лишь столько, сколько возможно», — сказал Кейз. «Предположим, у вас есть только 30 чернокожих людей в наборе данных. Экстраполяция может помочь, но если эти 30 человек все среднего класса или все светлокожие, то ‘репрезентативные’ данные будут выглядеть именно так.»

По этому поводу, исследование 2023 года, проведенное исследователями из Университета Райса и Стэнфорда, показало, что чрезмерная зависимость от синтетических данных во время обучения может создавать модели, чье качество или разнообразие постепенно уменьшаются. Предвзятость выборки — плохое представление реального мира — вызывает ухудшение разнообразия модели после нескольких поколений обучения, согласно исследователям,хотя они также обнаружили, что смешивание с небольшим количеством реальных данных помогает смягчить это.

Кейз видит дополнительные риски в сложных моделях, таких как o1 от OpenAI, которые, по его мнению, могут создавать труднее обнаруживаемые галлюцинации в своих синтетических данных. Это, в свою очередь, может снизить точность моделей, обученных на таких данных — особенно если источники галлюцинаций не легко идентифицировать.

«Сложные модели галлюцинируют; данные, произведенные сложными моделями, содержат галлюцинации», — добавил Кейс. «И с моделью, подобной o1, сами разработчики не могут в полной мере объяснить, почему появляются артефакты».

Накопление галлюцинаций может привести к моделям, которые выдают бессмыслицу. Исследование, опубликованное в журнале Nature, показывает, как модели, обученные на данных с ошибками, генерируют еще больше данных с ошибками, и как этот цикл отрицательно влияет на будущие поколения моделей. Исследователи обнаружили, что модели теряют понимание более сложных знаний с течением времени, становясь более общими и часто выдавая ответы, не относящиеся к заданным вопросам.

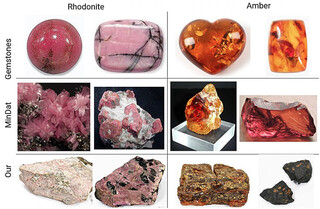

Последующее исследование показывает, что другие типы моделей, такие как генераторы изображений, также не застрахованы от такого рода деградации:

Солдайни соглашается, что «сырьевые» синтетические данные не заслуживают доверия, по крайней мере, если цель — избежать обучения забывчивых чат-ботов и однообразных генераторов изображений. Использовать их «безопасно», по его словам, можно, тщательно проверяя, курируя и фильтруя их, и, в идеале, сочетая с новыми, реальными данными — так же, как вы бы поступили с любым другим набором данных.

Если этого не сделать, это может в конечном итоге привести к деградации моделей, когда модель становится менее креативной и более предвзятой в своих выводах, что, в конечном счете, может серьезно скомпрометировать ее функциональность. Хотя этот процесс можно выявить и остановить до того, как он станет серьезным, это все равно риск.

«Исследователям нужно изучать сгенерированные данные, повторять процесс генерации и определять меры защиты для удаления некачественных данных», — сказал Солдайни. «Синтетические данные не являются самоулучшающейся машиной; их выходные данные должны быть тщательно проверены и улучшены перед использованием для обучения».

Генеральный директор OpenAI Сэм Альтман однажды утверждал, что AI когда-нибудь сможет создавать синтетические данные, достаточно хорошие для самостоятельного обучения. Но — даже если это возможно — такая технология еще не существует. Ни одна крупная лаборатория AI не выпустила модель, обученную только на синтетических данных.

*Meta и её продукты (Facebook, Instagram) запрещены на территории Российской Федерации

Источник

Источник новости: habr.com