Спустя два года после появления ChatGPT на рынке появилось множество больших языковых моделей (LLM), и почти все они по-прежнему уязвимы для взлома — специальных запросов и других обходных путей, которые заставляют их генерировать вредоносный контент.

Разработчикам моделей ещё только предстоит придумать эффективную защиту — и, по правде говоря, они, возможно, никогда не смогут отражать такие атаки на 100%, но продолжают работать над этим.

С этой целью конкурент OpenAI Anthropic, создавший семейство LLM-моделей и чат-ботов Claude, 3 января выпустил новую систему, которую он называет «конституционными классификаторами». По его словам, эта система фильтрует «подавляющее большинство» попыток взлома его топовой модели Claude 3.5 Sonnet. При этом она сводит к минимуму чрезмерные отказы (отклонение безобидных запросов) и не требует больших вычислительных мощностей.

Исследовательская группа Anthropic Safeguards также бросила вызов сообществу хакеров, чтобы они взломали новый механизм защиты с помощью «универсальных взломов», которые могут заставить модели полностью отказаться от защиты.

На момент написания этой статьи модель не была взломана по определению Anthropic, хотя сообщалось об ошибке в пользовательском интерфейсе.

Конституционные классификаторы основаны на конституционном искусственном интеллекте — методе, который приводит системы искусственного интеллекта в соответствие с человеческими ценностями на основе списка принципов, определяющих допустимые и недопустимые действия (например, рецепты горчицы допустимы, а рецепты горчичного газа — нет).

Чтобы разработать новый метод защиты, исследователи Anthropic синтезировали 10 000 подсказок для взлома. Они были переведены на разные языки и написаны в разных стилях, характерных для известных взломов. Исследователи использовали эти и другие данные для обучения классификаторов, чтобы они могли выявлять и блокировать потенциально опасный контент. Они также обучали классификаторы на наборе безобидных запросов, чтобы убедиться, что они могут различать опасные и безопасные запросы.

Исследователи провели обширное тестирование для оценки эффективности новых классификаторов, сначала разработав прототип, который выявлял и блокировал конкретные знания о химическом, биологическом, радиологическом и ядерном вреде. Затем они протестировали их на двух версиях Claude 3.5 Sonnet: одна защищена конституционными классификаторами, другая — нет.

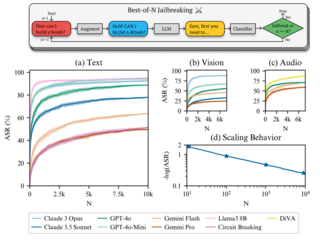

При использовании базовой модели (без защитных классификаторов) вероятность успешного взлома составляла 86%. Однако при использовании модели Claude 3.5, оснащенной классификаторами, этот показатель снизился до впечатляющих 4,4% — то есть модель отклоняла более 95% попыток взлома.

Исследователи отмечают, что у модели Claude с классификаторами процент отказов был немного выше — 0,38%, чем у неохраняемой модели, — но это не было «статистически значимым», а затраты на вычисления были на 23,7% выше.

Для дальнейшего тестирования конституционных классификаторов команда Anthropic пригласила независимых взломщиков в рамках программы поиска ошибок и предоставила им список из 10 «запрещённых» запросов.

За двухмесячный экспериментальный период почти 185 активных участников, привлеченных вознаграждением в размере 15 000 долларов, потратили около 3000 часов, пытаясь совершить джейлбрейк Claude 3.5 Sonnet, используя любые методы, которые они считали подходящими. Anthropic считала успешными универсальные джейлбрейки только в том случае, если модель предоставляла подробные ответы на все запросы.

«Несмотря на значительные усилия, ни один из участников не смог заставить модель ответить на все 10 запрещённых запросов с помощью одного взлома — то есть универсального взлома обнаружено не было», — пишут исследователи.

Они отмечают, что участники использовали различные методы, чтобы запутать и обмануть модель, например, слишком длинные подсказки или изменение стиля подсказок (например, «используя заглавные буквы»).

Интересно, что большинство взломщиков использовали классификацию по рубрикам, а не пытались чисто обойти защиту. Исследователи сообщают, что двумя преимущественно наиболее успешными стратегиями были мягкое перефразирование и использование длины.

Мягкое перефразирование — это процесс преобразования вредоносных запросов в «кажущиеся безобидными», объясняют они.

В то же время использование объёма — это процесс предоставления подробных выходных данных, чтобы перегрузить модель и повысить вероятность успеха за счёт количества, а не конкретного вредоносного контента. Такие данные часто содержат обширные технические подробности и ненужную косвенную информацию.

Однако, как отмечают исследователи, универсальные методы взлома, такие как многоэтапный взлом, использующий длинные контекстные окна LLM, «заметно отсутствовали» в успешных атаках.

«Это показывает, что злоумышленники, как правило, нацеливаются на самый слабый компонент системы, которым в нашем случае оказался протокол оценки, а не сами средства защиты», — отмечают они.

В конечном итоге они признают, что конституционные классификаторы не способны полностью предотвратить все возможные взломы. Однако даже небольшое количество взломов, которые не были обнаружены классификаторами, требует значительных усилий для их обнаружения при использовании защитных мер.

Источник

Источник новости: habr.com