Хотя генеративный ИИ активно осваивается миром, и новости о нём поступают со всех концов света, почти ничего не рассказывается об аппаратных мощностях, стоящих за обучением больших языковых моделей (LLM). Как сообщает HPC Wire, ситуацию попытался изменить IT-центр CSC, рассказав о роли европейского суперкомпьютера LUMI в создании LLM для финского языка. Без LUMI обучение модели удалось бы завершить только в 2025 году.

Суперкомпьютер LUMI является самым быстрым в Европе и занимает третье место в рейтинге TOP500. LUMI помог в обучении модели TurkuNLP, создававшейся под патронажем учёных из Университета Турку, сумевших сформировать «крупнейшую языковую модель для финского языка за всю историю». Новая ИИ-модель на базе GPT-3 включает 13 млрд параметров — известно, что до TurkuNLP в рамках пилотного проекта создавались и более скромные варианты. Финскому научили и многоязыковую модель BLOOM со 176 млрд параметров.

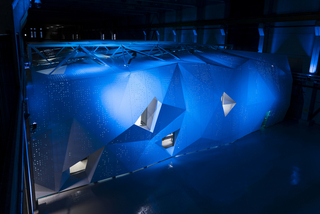

Дата-центр LUMI (Фото: Fade Creative)

Делить машинное время пришлось со многими другими проектами, по некоторым данным, исследователи временами регистрировали производительность на уровне 75–80 % от расчётной, хотя даже такие показатели признаны неплохими. Поскольку LUMI использует ускорители AMD Instinct MI250X, на их оптимизацию кода под новое «железо» ушло немало времени. Впрочем, группа учёных получила поддержку от команды LUMI User Support Team, AMD и Hugging Face.

Источник изображения: LUMI

Ещё одной нетривиальной задачей стал поиск материалов на финском языке для тренировки модели. Финны — довольно немногочисленный народ, поэтому исходного «сырья» для обучения в мире оцифровано относительно немного. Тексты в электронном виде добывались из всех возможных источников, при этом перед учёными стояла задача отфильтровать контент с ругательствами или материалами, разжигающими ненависть.

По данным учёных, им удалось вдвое сократить число спонтанной ругани в сравнении с предыдущими моделями благодаря качественным материалам, использовавшимся для обучения. Перед обучением также пришлось вычистить все персональные данные. Модель опубликована в Сети, но команда уже получила грант на 2 млн GPU-часов в рамках проекта LUMI Extreme Scale, поэтому исследования продолжатся.

Источник новости: servernews.ru