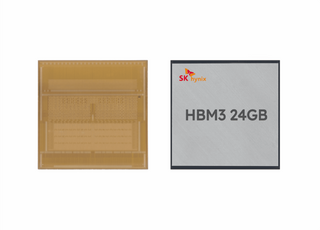

Sk hynix анонсировала, что компания приступила к производству пробных чипов памяти HBM3 с 12 слоями, что позволило достичь емкость 24 Гбайт на чип HBM3. Массовое производство запланировано на первую половину 2023, первые клиенты уже получили образцы.

Ранее Sk hynix выпускала чипы HBM3 с восемью слоями (помимо слоя ввода/вывода) и емкостью 16 Гбайт. В таком виде они использовались на ускорителях NVIDIA H100. Благодаря увеличению емкости на 50%, NVIDIA может оснастить ускоритель H100 120 или 144 Гбайт памяти. На данный момент емкость ограничена 80 или 94 Гбайт.

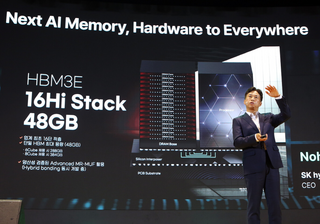

Пока неизвестно, в каких продуктах будет использоваться память HBM3 емкостью 24 Гбайт на чип. Производители памяти обычно это не комментируют. Сегодня у всех на слуху сети LLM (Large Language Models), которым требуется максимально возможная емкость памяти, чтобы рядом с GPU было доступно как можно больше параметров модели.

Источник новости: www.playground.ru