В Массачусетском технологическом институте (MIT) представили метод PhotoGuard, который усложняет изменение изображений при помощи нейросетей. Разработчики надеются, что он поможет предотвратить кражу контента и сдержит создание дипфейков.

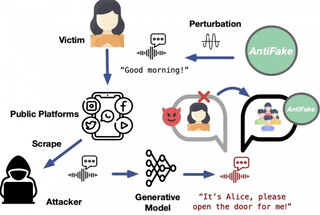

PhotoGuard работает в соответствии с двумя типами атак на ИИ-алгоритмы. Первый метод, который в MIT назвали «кодировщик», изменяет отдельные пиксели изображения. Эти артефакты невидимы для человеческого глаза, но легко считываются машинами. Они не позволяют ИИ понять, что изображено на картинке, и отредактировать её.

Второй метод, «диффузионный», маскирует для ИИ одно изображение под другое. В результате ИИ пытается изменить изображение, которое «видит», и генерируемая им картинка получается нереалистичной.

Учёные надеются, что сотрудничество с разработчиками ИИ-моделей, платформами социальных сетей и политиками поможет обеспечить надёжную защиту от несанкционированных манипуляций с изображениями.

«Компании, которые разрабатывают эти модели, должны инвестировать в разработку надёжных средств защиты от возможных угроз, которые создаются инструментами искусственного интеллекта», — заключил в беседе с Engadget докторант MIT и ведущий автор статьи Хади Салман.

Источник новости: habr.com