Группа нынешних и бывших сотрудников ведущих ИИ-компаний, таких как OpenAI и Google DeepMind, объединилась, чтобы выразить свою обеспокоенность по поводу необходимости усиления мер безопасности в быстро развивающейся области ИИ. В письме под названием «На эту тему есть отдельное большое совместное письмо», подписанном более чем десятком инсайдеров в области ИИ, отмечается, что, хотя ИИ способен принести человечеству невероятные выгоды, существуют и серьезные риски.  ИИ уже почти везде. Но безопасно ли им пользоваться? Изображение: Высшая школа экономики Опасен ли ИИ Эти риски варьируются от усиления существующего неравенства до распространения дезинформации и даже возможности таких последствий, как вымирание человечества в результате действий «злого» ИИ. Подписавшие письмо подчеркнули, что эти опасения разделяют не только они, но и правительства, другие эксперты в области ИИ и даже сами компании. Ниже вы можете посмотреть полный текст письма, но мы просто обсудим его содержимое.

ИИ уже почти везде. Но безопасно ли им пользоваться? Изображение: Высшая школа экономики Опасен ли ИИ Эти риски варьируются от усиления существующего неравенства до распространения дезинформации и даже возможности таких последствий, как вымирание человечества в результате действий «злого» ИИ. Подписавшие письмо подчеркнули, что эти опасения разделяют не только они, но и правительства, другие эксперты в области ИИ и даже сами компании. Ниже вы можете посмотреть полный текст письма, но мы просто обсудим его содержимое.  Изображение: ighttowarn.ai

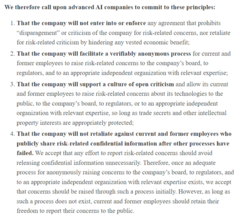

Изображение: ighttowarn.ai  Сам факт существования такого письма говорит о том, что нам есть из-за чего переживать. Изображение: ighttowarn.ai Если в двух словах, авторы говорят о том, что компании, занимающиеся разработкой искусственного интеллекта, возможно, слишком сосредоточены на зарабатывании денег и недостаточно сосредоточены на обеспечении безопасности своих технологий. Они считают, что нынешний подход, позволяющий компаниям саморегулироваться и добровольно делиться информацией о своих системах искусственного интеллекта, недостаточен для борьбы с потенциальными рисками. Не забывайте о нашем Дзен, где очень много всего интересного и познавательного! Как зищититься от искусственного интеллекта Чтобы решить эту проблему, сотрудники предложили несколько идей. Они считают, что ИИ-компании должны обещать не наказывать сотрудников, которые высказывают опасения, создавать анонимные способы сообщить о проблемах и поощрять открытое обсуждение рисков, связанных с ИИ. Они также считают, что нынешние и бывшие сотрудники должны иметь возможность открыто говорить о своих проблемах при условии, что они не разглашают секреты компании. Этот призыв к действию прозвучал после недавних противоречий в мире ИИ, таких как расформирование команды по безопасности OpenAI и уход некоторых ключевых фигур, которые занимались вопросами безопасности. Интересно, что письмо поддержал Джеффри Хинтон, уважаемый человек в мире ИИ, который недавно ушел из Google, чтобы более свободно говорить о потенциальных опасностях ИИ. Присоединяйтесь к нам в Telegram! Кто против ИИ Это открытое письмо — явное напоминание о том, что ИИ развивается так быстро, что правила и нормы еще не успели сформироваться. По мере того как ИИ становится все более мощным и появляется во все большем количестве мест его применения, становится очень важно обеспечить его безопасность и прозрачность.

Сам факт существования такого письма говорит о том, что нам есть из-за чего переживать. Изображение: ighttowarn.ai Если в двух словах, авторы говорят о том, что компании, занимающиеся разработкой искусственного интеллекта, возможно, слишком сосредоточены на зарабатывании денег и недостаточно сосредоточены на обеспечении безопасности своих технологий. Они считают, что нынешний подход, позволяющий компаниям саморегулироваться и добровольно делиться информацией о своих системах искусственного интеллекта, недостаточен для борьбы с потенциальными рисками. Не забывайте о нашем Дзен, где очень много всего интересного и познавательного! Как зищититься от искусственного интеллекта Чтобы решить эту проблему, сотрудники предложили несколько идей. Они считают, что ИИ-компании должны обещать не наказывать сотрудников, которые высказывают опасения, создавать анонимные способы сообщить о проблемах и поощрять открытое обсуждение рисков, связанных с ИИ. Они также считают, что нынешние и бывшие сотрудники должны иметь возможность открыто говорить о своих проблемах при условии, что они не разглашают секреты компании. Этот призыв к действию прозвучал после недавних противоречий в мире ИИ, таких как расформирование команды по безопасности OpenAI и уход некоторых ключевых фигур, которые занимались вопросами безопасности. Интересно, что письмо поддержал Джеффри Хинтон, уважаемый человек в мире ИИ, который недавно ушел из Google, чтобы более свободно говорить о потенциальных опасностях ИИ. Присоединяйтесь к нам в Telegram! Кто против ИИ Это открытое письмо — явное напоминание о том, что ИИ развивается так быстро, что правила и нормы еще не успели сформироваться. По мере того как ИИ становится все более мощным и появляется во все большем количестве мест его применения, становится очень важно обеспечить его безопасность и прозрачность.  Письмо было подписано не одним человеком. Изображение: ighttowarn.ai Представители OpenAI не остались в стороне и прокомментировали это письмо нашим коллегам из издания Android Authority. Они заявили, что гордятся своей работой и тем, что могут предоставить самые умные и безопасные системы ИИ. То есть, они не согласны с тем, что их система несет риски, как и другие подобные. При этом, они согласны с тем, что строгие дебаты крайне важны, учитывая значимость этой технологии. А также они пообещали продолжать взаимодействовать с правительствами, гражданским обществом и другими сообществами по всему миру. Это уже обнадеживает, ведь только так можно снизить риск выхода системы из-под контроля. С другой стороны, сказать можно все, что угодно.

Письмо было подписано не одним человеком. Изображение: ighttowarn.ai Представители OpenAI не остались в стороне и прокомментировали это письмо нашим коллегам из издания Android Authority. Они заявили, что гордятся своей работой и тем, что могут предоставить самые умные и безопасные системы ИИ. То есть, они не согласны с тем, что их система несет риски, как и другие подобные. При этом, они согласны с тем, что строгие дебаты крайне важны, учитывая значимость этой технологии. А также они пообещали продолжать взаимодействовать с правительствами, гражданским обществом и другими сообществами по всему миру. Это уже обнадеживает, ведь только так можно снизить риск выхода системы из-под контроля. С другой стороны, сказать можно все, что угодно.  ИИ несет пользу, но бесконтрольное его распространение может быть опасным. Изображение: Android Authority Безопасно ли пользоваться искусственным интеллектом Говоря о своей репутации в области безопасности, OpenAI отмечает, что в прошлом компания не выпускала технологию до тех пор, пока не были разработаны необходимые меры защиты. Компания вновь заявила о своей поддержке регулирования и развития безопасности ИИ. В ответ на опасения по поводу ответных мер представитель подтвердил, что компания освободила всех бывших сотрудников от соглашений о неразглашении информации и удалила подобные пункты из стандартных документов об увольнении. Если ищите что-то интересное на AliExpress, не проходите мимо Telegram-канала "Сундук Али-Бабы"! Однако OpenAI также подчеркнула важность сохранения конфиденциальности, заявив, что, хотя компания ценит открытый диалог, обсуждения не должны ставить под угрозу безопасность ее технологии. Компания выразила обеспокоенность по поводу возможного раскрытия информации конкурентам, которые могут злоупотребить технологией и нанести ущерб OpenAI.

ИИ несет пользу, но бесконтрольное его распространение может быть опасным. Изображение: Android Authority Безопасно ли пользоваться искусственным интеллектом Говоря о своей репутации в области безопасности, OpenAI отмечает, что в прошлом компания не выпускала технологию до тех пор, пока не были разработаны необходимые меры защиты. Компания вновь заявила о своей поддержке регулирования и развития безопасности ИИ. В ответ на опасения по поводу ответных мер представитель подтвердил, что компания освободила всех бывших сотрудников от соглашений о неразглашении информации и удалила подобные пункты из стандартных документов об увольнении. Если ищите что-то интересное на AliExpress, не проходите мимо Telegram-канала "Сундук Али-Бабы"! Однако OpenAI также подчеркнула важность сохранения конфиденциальности, заявив, что, хотя компания ценит открытый диалог, обсуждения не должны ставить под угрозу безопасность ее технологии. Компания выразила обеспокоенность по поводу возможного раскрытия информации конкурентам, которые могут злоупотребить технологией и нанести ущерб OpenAI.

Источник новости: androidinsider.ru