Системы искусственного интеллекта на основе больших языковых моделей (LLM) становятся все более доступными способами получения ответов и советов, несмотря на некоторые расовые и гендерные предубеждения.

Новое исследование обнаружило убедительные доказательства того, что теперь к этому списку можно добавить и политическую предвзятость, что еще больше демонстрирует потенциал новой технологии невольно влиять на политические взгляды общества.

Исследование, проведенное компьютерным ученым Дэвидом Розадо из Политехнического института Отаго в Новой Зеландии, поднимает вопросы о том, как на нас могут влиять ИИ чат-боты, на которых мы полагаемся в получении различной информации.

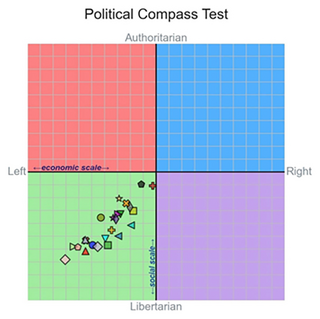

Розадо проверил 11 стандартных политических опросников, таких как тест Политический компас, на 24 различных LLM, включая ChatGPT от OpenAI и чат-бот Gemini, разработанного Google, и обнаружил, что средняя политическая позиция всех моделей не была близка к нейтральной.Левоцентристские предпочтения LLM. (Rozado, PLOS ONE, 2024)

Исследователь отмечает, что большинство существующих LLM демонстрируют левоцентристские политические предпочтения, когда их оценивают с помощью различных тестов на политические взгляды.

Средний левый уклон не был сильным, но он был значительным. Дальнейшие тесты на пользовательских ботах, где пользователи могут точно настроить обучающие данные LLM, показали, что на данные ИИ можно повлиять, чтобы они выражали политические пристрастия, используя левоцентристские или правоцентристские тексты.

Розадо также рассмотрел базовые модели, такие как GPT-3.5, на которых основаны разговорные чат-боты. Здесь не было обнаружено никаких признаков политической предвзятости, хотя без фронтэнда чат-бота было сложно сопоставить ответы в осмысленном виде.

«Поскольку LLM начинают частично вытеснять традиционные источники информации, такие как поисковые системы и Википедия, последствия для общества, связанные с политическими предубеждениями, заложенными в LLM, весьма существенны», — пишет Розадо в своей опубликованной работе.

Каким образом эти предубеждения попадают в системы, пока неясно, хотя нет никаких предположений, что они намеренно закладываются разработчиками LLM. Эти модели обучаются на огромном количестве онлайн-текстов, но дисбаланс левого и правого материала может оказать влияние.

По словам Розадо, доминирование ChatGPT в обучении других моделей также может быть фактором, поскольку ранее бот демонстрировал левоцентристские взгляды на политику.

«Очень важно критически изучить и устранить потенциальные политические предубеждения, заложенные в LLM, чтобы обеспечить сбалансированное, справедливое и точное представление информации в их ответах на запросы пользователей», — пишет Розадо.

Исследование было опубликовано в журнале PLOS ONE.

Источник новости: habr.com