В августе 2023 года Microsoft развернула в своём облаке Azure инстансы ND H100 v5 на базе NVIDIA H100 для HPC-вычислений и нагрузок ИИ. А теперь запущены машины ND H200 v5 с ускорителями NVIDIA H200, оптимизированные для инференса и обучения больших языковых моделей (LLM).

Новые инстансы объединяют восемь ускорителей NVIDIA H200, каждый из которых содержит 141 Гбайт памяти HBM3e с пропускной способностью 4,8 Тбайт/с. По сравнению с NVIDIA H100 объём памяти увеличился на 76 %, пропускная способность — на 43 %.

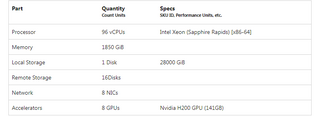

Для ND H200 v5 предусмотрена возможность масштабирования до тысяч ускорителей при помощи интерконнекта на базе NVIDIA Quantum-2 CX7 InfiniBand с пропускной способностью до 400 Гбит/с в расчёте на ускоритель (до 3,2 Тбит/с на виртуальную машину). В составе инстансов задействованы чипы Intel Xeon поколения Sapphire Rapids: каждая виртуальная машина насчитывает 96 vCPU. Объём памяти составляет 1850 Гбайт, вместимость локального хранилища — 28 000 Гбайт. Обеспечивается доступ к 16 облачным накопителям. Кроме того, используются восемь сетевых адаптеров (суммарно до 80 Гбит/c).

Источник изображения: Microsoft

Виртуальные машины ND H200 v5 имеют предварительную интеграцию с Azure Batch, Azure Kubernetes Service, Azure OpenAI Service и Azure Machine Learning. Говорится, что инстансы обеспечивают высокую производительность при решении различных задач, связанных с ИИ, машинным обучением и аналитикой данных.

Источник новости: servernews.ru