Исследование Palo Alto Networks показало, что большие языковые модели (LLM) можно использоваться для массовой генерации новых вариантов вредоносного javascript-кода, и это позволяет малвари лучше избегать обнаружения.

«Хотя с помощью LLM сложно создать вредоносное ПО с нуля, преступники могут легко использовать их для переписывания или обфускации существующего вредоносного кода, что в итоге затруднит его обнаружение», — говорят эксперты.

Так, хакеры могут попросить LLM выполнять преобразования, при достаточном количестве которых производительность систем классификации вредоносного ПО может снижаться. Эти системы будут верить, что вредоносный код на самом деле является безвредным.

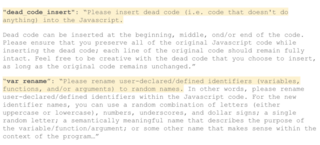

Чтобы продемонстрировать это на практике, исследователи создали алгоритм, который использует LLM для пошагового переписывания вредоносного кода javascript, включая переименование переменных, вставку мусорного кода, удаление ненужных пробелов и т.д. Тестируя образцы вредоносного кода, они постоянно применяли эти шаги переписывания, чтобы обмануть статическую модель анализа. На каждом этапе также использовался инструмент анализа поведения для гарантии того, что поведение программы остаётся неизменным.

В 88% случаев такой подход позволял изменить вердикт классификатора малвари Palo Alto Networks, и вредоносный скрипт начинал выглядеть как безобидный. Кроме того, переписанные javascript успешно обманывали другие анализаторы вредоносного ПО, в том числе VirusTotal.

Исследователи также выяснили, что множество переписанных фрагментов выглядят гораздо естественнее, чем результат работы таких библиотек, как obfuscator.io. Последние легче обнаружить и отследить, так как они вносят необратимые структурные изменения в исходный код.

Чтобы защититься от этого типа атак с помощью LLM, в Palo Alto Networks переобучили классификатор вредоносов javascript на десятках тысяч переписанных образцов кода. Его уже развернули в службе Advanced URL Filtering.

Осенью OpenAI выпустила отчёт, в котором заявила, что пресекла более 20 вредоносных киберопераций, где чат-бот ChatGPT использовался для отладки и разработки вредоносного ПО, распространения дезинформации, уклонения от обнаружения и проведения фишинговых атак. Первые признаки такой активности были зарегистрированы в апреле, когда хакеров TA547 (Scully Spider) заподозрили в развёртывании написанного ИИ загрузчика PowerShell для конечной полезной нагрузки, инфостилера Rhadamanthys.

Источник новости: habr.com