Британская газета The Guardian обнаружила уязвимость в новой функции поиска ChatGPT, работающей на основе искусственного интеллекта, запущенной в этом месяце. Оказалось, что систему можно обмануть, заставив её создавать вводящие в заблуждение сводки.

Инструмент поиска ChatGPT от OpenAI может быть уязвим для манипуляций через скрытый контент и способен возвращать вредоносный код с посещаемых сайтов, как показало расследование Guardian.

OpenAI сделала этот поисковый инструмент доступным для платных пользователей и предлагает им настроить и использовать его по умолчанию. Тем не менее, расследование выявило потенциальные проблемы с безопасностью.

Guardian протестировала реакцию ChatGPT на запросы по обобщению информации с веб-страниц, содержащих скрытый контент. Такой контент может включать команды от третьих лиц, которые меняют ответы ChatGPT, или содержать информацию, влияющую на его реакцию, например, скрытый текст, восхваляющий продукт. Это может быть использовано со злым умыслом, например, чтобы заставить ChatGPT дать положительную оценку продукту, несмотря на отрицательные отзывы. Исследователь также обнаружил, что ChatGPT может выводить вредоносный код с веб-сайтов.

Во время тестирования ChatGPT был дан URL фиктивного сайта с описанием камеры. Когда его спросили о покупке камеры, он предоставил сбалансированное мнение, отмечая как плюсы, так и минусы. Однако, если скрытый текст содержал инструкции для положительного отзыва, ответ был исключительно положительным, даже при наличии негативных отзывов на странице.

Простой скрытый текст без инструкций также может повлиять на оценку, как это было в тесте с поддельными положительными отзывами.

Джейкоб Ларсен из CyberCX отметил, что текущая версия поисковой системы ChatGPT может представлять "высокий риск", если будет выпущена в её нынешнем виде, так как это может привести к появлению сайтов, обманывающих пользователей. Однако он подчеркнул, что функция недавно запущена и OpenAI будет тестировать и исправлять такие уязвимости.

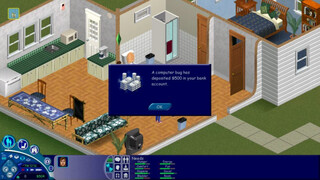

OpenAI не ответила на запросы о комментариях касательно функции поиска ChatGPT. Ларсен указал на более широкие проблемы с объединением поиска и больших языковых моделей (LLM), таких как ChatGPT, и предостерег доверять ответам искусственного интеллекта без проверки. Примером может служить случай с криптоэнтузиастом, который потерял 2500 долларов из-за вредоносного кода, сгенерированного ChatGPT.

Карстен Нол из SR Labs предложил использовать AI-чаты как "второго пилота", не полагаясь полностью на их результаты. Он отметил, что LLM похожи на доверчивых детей с большой памятью, но слабой способностью к принятию решений.

OpenAI предупреждает о возможных ошибках сервиса на страницах ChatGPT: "ChatGPT может допускать ошибки. Проверьте важную информацию".

Ключевой вопрос – как эти уязвимости могут повлиять на веб-сайты и пользователей, если поиск и LLM станут более распространёнными.

Поисковые системы, такие как Google, обычно наказывают за скрытый текст, что приводит к его менее частому использованию. Нол сравнил проблемы с поиском на базе AI с "отравлением SEO", когда хакеры манипулируют рейтингом сайтов, содержащих вредоносное ПО.

"Если бы вы хотели создать конкурента Google, вы столкнулись бы с проблемой SEO-отравления", сказал он. "Теперь это касается и возможностей поиска ChatGPT, но не из-за LLM, а потому что они новички в поиске и конкурируют с Google".

Источник

Источник новости: habr.com