В последние годы технологи предупреждали о потенциальных катастрофических рисках, связанных с развитием продвинутых систем AI. Однако в 2024 году эти предупреждения были заглушены практичным и успешным видением генеративного AI, продвигаемым технологической индустрией, что также принесло значительную прибыль компаниям.

Тех, кто обеспокоен возможными негативными последствиями AI, часто называют «AI doomers». Они опасаются, что системы AI могут принимать решения, приводящие к гибели людей, использоваться для угнетения масс или способствовать общему упадку общества.

В 2023 году темы безопасности AI и рисков, связанных с AI, перешли из узкой сферы обсуждений в общественное пространство, появляясь в медиа и на первых полосах главных изданий. Призыв Илона Маска и более 1000 технологов и ученых приостановить развитие AI и подготовиться к рискам. Вскоре последовали подписанием открытого письма ведущими учеными из OpenAI, Google и других лабораторий о необходимости серьезного восприятия риска вымирания человечества из-за AI.

Однако предприниматели из Силиконовой долины не согласились оставить развитие AI без контроля. Сооснователь a16z Марк Андрессен в июне 2023 года опубликовал эссе «Почему AI спасет мир», в котором опровергает аргументы «AI doomers» и представляет оптимистичное видение развития технологии. Он утверждал, что компании должны развивать AI максимально быстро и агрессивно, с минимальными регуляторными ограничениями, чтобы избежать монополизации технологии и обеспечить конкурентоспособность с Китаем.

Эта позиция получила поддержку среди многих стартапов и крупных компаний, инвестирующих в AI. Несмотря на обеспокоенность некоторых инвесторов и исследователей, инвестиции в AI в 2024 году достигли рекордных показателей. Генеральный директор OpenAI Сэм Альтман быстро вернулся к руководству компанией после краткого ухода, однако некоторые исследователи по безопасности покинули организацию, выражая обеспокоенность снижением культуры безопасности.

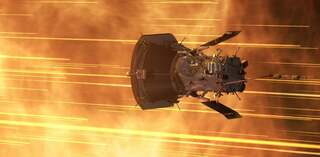

Технологические гиганты продолжили внедрять инновационные AI-продукты, демонстрируя, как концепции из научной фантастики воплощаются в реальность. OpenAI представила возможность общения с телефонами без необходимости физического взаимодействия, а Meta выпустила умные очки с реальным временем визуального понимания.

Тем временем, среди технологов и инвесторов росло мнение, что «AI doomers» не только против технологий, но и придерживаются нереалистичных взглядов. Известные ученые и инвесторы, такие как Янн Лекун из Meta*, становились все более откровенными в своих заявлениях о безопасности AI, подчеркивая, что опасения о захвате человечества интеллектуальными системами преувеличены.

Несмотря на продолжающиеся дебаты, в 2024 году доминировало мнение, что развитие AI должно идти вперед с минимальными ограничениями, ориентируясь на потенциал технологии спасать мир и преобразовывать различные сферы жизни. Однако случаи, такие как судебные разбирательства с AI-чатботами, подчеркивают необходимость разработки новых стандартов безопасности и этических норм в эпоху AI.

В 2025 году ожидается дальнейшее развитие дискуссий о безопасности AI и регулировании технологии, однако на данный момент доминирует оптимистичный настрой, продвигаемый лидерами индустрии, направленный на быстрое и непрерывное развитие AI.

Meta и ее продукты (Instagram,Facebok) запрещены на территории Российской Федерации

Источник

Источник новости: habr.com