Исследователи Google разработали новый тип модели Transformer, которая дает языковым моделям нечто похожее на долговременную память. Система может обрабатывать гораздо более длинные последовательности информации, чем текущие модели, что приводит к лучшей производительности при выполнении различных задач.

Новая архитектура «Titans» черпает вдохновение из того, как работает человеческая память. Объединяя искусственную краткосрочную и долгосрочную память через блоки внимания и MLP памяти, система может работать с длинными последовательностями информации.

Одной из умных функций системы является то, как она решает, что запоминать. Titans использует «удивленность» в качестве своей основной метрики — чем неожиданнее информация, тем больше вероятность, что она сохранится в долговременной памяти. Система также знает, когда следует забывать вещи, что помогает ей эффективно использовать пространство памяти.

Команда создала три разные версии Titans, каждая из которых по-разному обрабатывает долговременную память: память как контекст (MAC), память как контроль доступа (ворота) (MAG), память как слой (MAL). Хотя каждая версия имеет свои сильные стороны, вариант MAC особенно хорошо работает с очень длинными последовательностями.

В ходе обширного тестирования Titans превзошли традиционные модели, такие как классический Transformer, и более новые гибридные модели, такие как Mamba2, особенно при работе с очень длинными текстами. Команда утверждает, что он может эффективнее обрабатывать контекстные окна более 2 миллионов токенов, устанавливая новые рекорды как для моделирования языка, так и для прогнозирования временных рядов с длинными контекстами.

Система также преуспела в тесте «Иголка в стоге сена», где ей нужно найти определенную информацию в очень длинных текстах. Titans достигла точности более 95% даже с текстами из 16 000 токенов. Хотя некоторые модели от OpenAI, Anthropic и Google работают лучше, они намного больше — самая большая версия Titans имеет всего 760 миллионов параметров.Модели Titans также значительно превосходят более крупные языковые модели в задачах, требующих понимания более обширных контекстов

Titans действительно показала свою силу в тесте BABILong , сложном тесте на долгосрочное понимание, где модели должны связывать факты, разбросанные по очень длинным документам. Система превзошла более крупные модели, такие как GPT-4 , RecurrentGemma-9B и Llama3.1-70B. Она даже превзошла Llama3 с Retrieval Augmented Generation (RAG), хотя некоторые специализированные модели поиска все еще работают лучше.

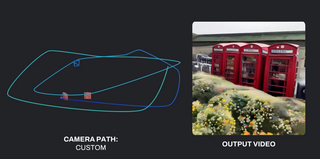

Команда рассчитывает сделать код общедоступным в ближайшем будущем. Хотя Titans и подобные архитектуры могут привести к языковым моделям, которые обрабатывают более длинные контексты и делают лучшие выводы, преимущества могут выйти за рамки простой обработки текста. Ранние тесты команды с моделированием ДНК показывают, что технология может улучшить и другие приложения, включая видео-модели, при условии, что многообещающие результаты тестов подтвердятся в реальном использовании.

Источник

Источник новости: habr.com