Согласно новому исследованию, проведенному исследователями Шанхайского университета Цзяо Тун, большие языковые модели (LLM) могут выполнять сложные задачи рассуждения, не полагаясь на большие наборы данных. Результаты исследования демонстрируют, что при использовании ограниченного количества тщательно отобранных образцов можно подготовить специалиста в области юриспруденции к выполнению задач, которые, как предполагалось, требуют огромного количества учебных материалов.

Такая эффективность обусловлена знаниями, которые современные большие языковые модели получают на этапе предварительного обучения. Благодаря новым методам обучения, которые становятся более эффективными с точки зрения использования данных и вычислений, предприятия смогут создавать индивидуальные модели, не прибегая к ресурсам крупных лабораторий AI.

В своем исследовании исследователи оспаривают предположение о том, что нужны большие объемы данных для обучения LLM выполнению задач на рассуждение. Они вводят концепцию «меньше значит больше» (LIMO). Их работа основывается на предыдущих исследованиях, которые показали, что LLM могут быть приведены в соответствие с предпочтениями человека на нескольких примерах. Меньше значит больше (LIMO) для рассуждений.

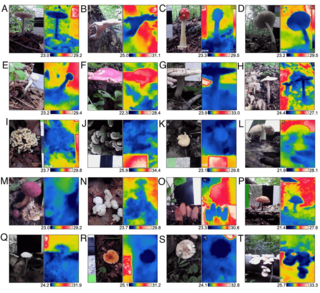

В своих экспериментах они продемонстрировали, что могут создать набор данных LIMO для сложных задач, связанных с математическими рассуждениями, с помощью нескольких сотен обучающих примеров. Модель LLM, обученная на этом наборе данных, смогла создавать сложные цепочки рассуждений (CoT), которые позволяли ей выполнять задачи с очень высокой вероятностью успеха.

Например, модель Qwen2.5-32B-Instruct, доработанная на 817 обучающих примерах, выбранных на основе LIMO, достигла 57,1% точности на сложном наборе тестов AIME и 94,8% на MATH, превзойдя модели, обученные на в сто раз большем количестве примеров. Он также показал более высокие результаты в тестах, чем модели логического мышления, такие как QwQ-32B-Preview (версия модели Qwen, обученная для логического мышления) и OpenAI o1-preview, которые были обучены на более объёмных данных и вычислительных ресурсах.

Более того, модели, обученные с помощью LIMO, обобщают информацию, сильно отличающуюся от обучающих данных. Например, в научном бенчмарке OlympiadBench модель LIMO превзошла QwQ-32B-Preview, а в сложном бенчмарке GPQA она достигла 66,7% точности, что близко к лучшему результату OpenAI-o1-preview — 73,3%.

Настройка LLM — привлекательный вариант использования для корпоративных приложений. Благодаря таким методам, как генерация с дополненным поиском (RAG) и обучение в контексте, LLM можно настроить для использования специальных данных или выполнения новых задач без необходимости дорогостоящей тонкой настройки.

Однако задачи, связанные с логическим мышлением, часто требуют обучения и тонкой настройки больших языковых моделей. Широко распространено мнение, что для таких задач требуются большие объёмы обучающих примеров с очень подробными цепочками рассуждений и решениями. Создание таких наборов данных занимает много времени и нецелесообразно для многих приложений и компаний.

Совсем недавно исследователи показали, что подходы к чистому обучению с подкреплением позволяют моделям самостоятельно обучаться решению задач, генерируя множество решений и выбирая наиболее эффективные. Хотя этот подход требует меньше ручного труда, он по-прежнему требует дорогостоящих вычислительных ресурсов, которые недоступны многим предприятиям.

С другой стороны, создание нескольких сотен примеров — это задача, с которой могут справиться многие компании, что делает специализированные модели рассуждений доступными для более широкого круга организаций.

«Это открытие имеет большое значение для исследований в области искусственного интеллекта: оно показывает, что даже сложные мыслительные способности на уровне соревнований можно эффективно развивать с помощью минимальных, но тщательно подобранных обучающих примеров», — пишут исследователи.

В ходе своих экспериментов исследователи выявили две основные причины, по которым LLM могут выполнять сложные логические задачи с меньшим количеством примеров.

Во-первых, современные базовые модели были обучены на очень большом количестве математического контента и кода во время предварительного обучения. Это означает, что эти большие языковые модели уже обладают обширными знаниями в области логики в своих параметрах, которые можно активировать с помощью тщательно подобранных примеров.

Во-вторых, новые методы постобучения показали, что если позволить моделям генерировать расширенные цепочки рассуждений, это значительно улучшит их способность к рассуждению. По сути, если дать моделям больше времени на «размышления», они смогут более эффективно использовать и применять свои предварительно обученные знания.

«Мы предполагаем, что успешное рассуждение возникает в результате взаимодействия этих двух факторов: обширных знаний, полученных в процессе обучения, и достаточных вычислительных ресурсов во время логического вывода, — пишут исследователи. — Эти разработки в совокупности указывают на поразительную возможность: если модели обладают обширными знаниями и имеют достаточно вычислительных ресурсов, то для активации их логических способностей может потребоваться лишь небольшое количество высококачественных обучающих примеров, которые способствуют длительному обдумыванию, а не массивные наборы данных для тонкой настройки».Выбор более сложных задач для включения в обучающий набор данных может существенно повлиять на точность обученной модели при выполнении логических задач.

Согласно выводам исследователей, создание полезных наборов данных LIMO зависит от выбора правильных проблем и решений. Кураторы данных должны уделять приоритетное внимание сложным проблемам, которые требуют сложных цепочек рассуждений, разнообразных мыслительных процессов и интеграции знаний. Проблемы также должны отличаться от распределения обучающей модели, чтобы стимулировать новые подходы к рассуждению и подталкивать ее к обобщению.

Соответственно, решения должны быть четкими и хорошо организованными, с этапами обоснования, адаптированными к сложности проблемы. Высококачественные решения также должны обеспечивать стратегическую образовательную поддержку путем постепенного углубления понимания с помощью тщательно структурированных объяснений.

«Сосредоточившись на минимальном, но тщательно подобранном наборе логических цепочек, мы воплощаем основной принцип LIMO: высококачественные демонстрации, а не просто объём данных, являются ключом к раскрытию возможностей сложного мышления», — пишут исследователи.

Исследователи опубликовали код и данные, использованные для обучения моделей LIMO в ходе экспериментов. В будущем они планируют расширить концепцию на другие области и приложения.

Источник

Источник новости: habr.com