Исследователи из Midjorney и Нью-Йоркского университета разработали новый подход, который может помочь языковым моделям генерировать более разнообразные креативные тексты без существенного ущерба качеству.

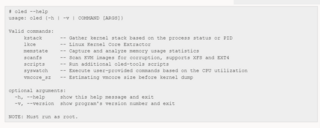

В недавно опубликованной статье команда вводит «метрики отклонения» в процесс обучения AI. Метод работает путем измерения того, насколько отличается каждый сгенерированный текст от других, созданных для той же подсказки. Эти различия вычисляются с использованием встроенных текстов и их парного косинусного расстояния — по сути, давая системе математический способ понимания вариации текста.Трехэтапная блок-схема: процесс улучшения ответов AI посредством анализа отклонений, обучения DPO/ORPO и диверсификации

Первоначальное тестирование выглядит многообещающим. Модели, использующие этот новый метод обучения, сгенерировали на 23 процента более разнообразные тексты, при этом показатели качества снизились всего на пять процентов, согласно системе вознаграждений Reddit.

Тестовый случай показывает, как это работает на практике. Когда давали подсказку, стандартная модель GPT-4o в основном придерживалась историй о нервных новых правителях. Модифицированная модель Llama-3.1-8B, несмотря на меньшие размеры, производила все, от темных фэнтезийных историй о медвежьих принцах до сверхъестественных историй, происходящих под водой.Модифицированные модели Llama демонстрируют большее разнообразие в повествовании по сравнению с GPT-4o с идентичными подсказками

Тестировщики подтвердили эти результаты, заявив, что тексты показали больше разнообразия при сохранении качества. Однако исследователи тестировали только старый GPT-4o, а не новый GPT-4.5, который производит более естественно звучащий текст, но стоит дороже.Данные показывают, что модифицированная модель превосходит другие как по качеству, так и по разнообразию историй

Исследователи сосредоточились на двух типах разнообразия: семантическом (разное содержание и сюжеты историй) и стилистическом (письмо, которое звучит так, как будто его написали разные авторы). Они разработали отдельные версии для каждого типа, но обнаружили, что лучше всего работает их объединение.

Для своего исследования команда использовала более 100 000 пар «подсказка-ответ» из Reddit r/WritingPrompts. Они обнаружили, что могут получить значительно большее разнообразие, используя всего четыре разных ответа на подсказку.

Система может поддерживать качество, используя тщательно отобранные обучающие примеры или устанавливая минимальные стандарты того, насколько разными должны быть ответы. Это делает ее более гибкой, чем другие методы увеличения выходного разнообразия.

Некоторые вопросы все еще требуют ответов. Исследователи пока не показали, работает ли их метод за пределами творческого письма — техническая документация и резюме могут потребовать иных подходов. Эффективность метода в среде онлайн-обучения, которую используют многие крупные модели, также остается непроверенной.

Система измерения качества сама по себе вызывает вопросы. Хотя оценки Reddit дают некоторое представление о качестве текста, они упускают из виду такие важные факторы, как техническая точность, последовательность и профессиональные стандарты письма. Эти ограничения указывают на то, что могут потребоваться более комплексные методы оценки.

Даже с этими открытыми вопросами эта техника может изменить то, как LLM справляются с творческими задачами письма, где текущие модели часто попадают в повторяющиеся шаблоны. Исследователи говорят, что они поделятся своим кодом на GitHub, чтобы другие могли развивать их работу.

Источник

Источник новости: habr.com