В новом исследовании, проведённом в Университете Цинхуа и Шанхайском университете Цзяо Тун, рассматривается вопрос о том, помогает ли обучение с подкреплением и верифицируемыми вознаграждениями (RLVR) крупным языковым моделям лучше рассуждать или просто делает их более эффективными при повторении известных решений.

Исследование показало, что RLVR повышает вероятность получения правильного ответа с первой попытки, так называемого [email=pass@1,]pass@1,[/email] но не открывает новых возможностей.

«RLVR не так эффективен, как считалось ранее, он не позволяет модели решать задачи, которые не может решить базовая модель», — пишет руководитель исследования Ян Юэ.

Генеральный директор OpenAI Сэм Альтман, по-видимому, знает об этих ограничениях. Он предположил, что сочетание способности к рассуждению с «гораздо более крупной моделью» посредством предварительного обучения может в конечном итоге привести к «первым фрагментам или своего рода признакам жизни в виде новых научных знаний», указывая на то, что масштаб, а не только обучение, может быть ключом к развитию способности к рассуждению.

RLVR в основном используется для обучения моделей рассуждения на задачах с проверяемыми результатами, таких как математика, программирование и визуальное мышление. Вместо того чтобы полагаться на обратную связь от человека, он использует автоматические сигналы, такие как правильные вычисления или пройденные тесты кода, в качестве критериев вознаграждения. Этот подход применялся в таких моделях, как o-series от OpenAI и Deepseek-R1.

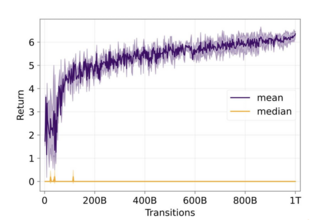

Исследование показывает, что RLVR уменьшает разнообразие результатов, называемое энтропией, за счёт концентрации реакций вокруг нескольких путей решения с высокой наградой. Это повышает шансы на успех с первой попытки, но ограничивает способность модели исследовать альтернативы в долгосрочной перспективе.

Исследователи сравнили базовые модели и варианты RLVR, используя метрику [email=pass@k,]pass@k,[/email] которая показывает, появляется ли хотя бы один правильный ответ среди нескольких попыток. Модели RLVR показали лучшие результаты, когда было выбрано всего несколько ответов, поскольку они ориентированы на стратегии с высокой вероятностью успеха. Однако, когда было сгенерировано больше ответов, базовые модели превзошли их, выдавая более широкий спектр ответов — независимо от конкретной модели или типа задачи.

Та же закономерность наблюдалась в задачах, связанных с математикой, программированием и визуальным мышлением. Модели, обученные RLVR, часто справлялись с заданиями с первой попытки, но демонстрировали более низкую производительность при тестировании в течение нескольких попыток.

Ручной анализ цепочки рассуждений (CoT) показал, что базовые модели уже способны решать сложные задачи, используя различные стратегии, некоторые из которых ранее приписывались только моделям, обученным на основе RL. Визуализация путей рассуждений подтвердила, что RLVR не привносит нового поведения, а вместо этого повышает вероятность выбора успешных стратегий, уже присутствующих в базовой модели. На графике показано, как обучение RLVR влияет на эффективность логического мышления в языковых моделях. Хотя оно повышает эффективность выполнения задачи A, оно ограничивает способность модели обобщать знания для выполнения задачи B, что подчёркивает компромиссы при оптимизации для разных типов задач.

Исследователь в области ИИ Натан Ламберт описывает результаты как соответствующие ожиданиям.

«Это не прорыв в интуиции, — отмечает он, — но это значительный прогресс». По мнению Ламберта, это «замечательно, поскольку демонстрирует, что RL снижает неопределённость выборок, но при этом делает модель более действенной с первой попытки».

Он также отмечает узкую направленность обучающих данных, указывая на то, что модели обучались только на наборах данных MATH и GSM8K, которые, по его словам, «отлично подходят для контролируемых экспериментов», но «не очень хорошо подходят для демонстрации фундаментальных ограничений обучения с подкреплением». Он утверждает, что для более широких выводов потребуется масштабирование подхода: «OpenAI и другие компании показали, что масштабирование обучения с подкреплением является его важнейшим аспектом, а с такими узкими наборами данных это невозможно».

Вместо того, чтобы критиковать обучение с подкреплением в целом, Ламберт предполагает, что исследование подчёркивает необходимость дальнейшего прогресса. По словам Ламберта, «мы просто подходим к тому моменту, когда нам нужно делать сложные вещи. Сложные вещи интереснее, но, к сожалению, они требуют больше времени».

Юэ отмечает, что исследование было сосредоточено на моделях RL, обученных с нуля, без таких усовершенствований, как тонкая настройка цепочки рассуждений или извлечение знаний: «Здесь мы сосредоточились на модели, обученной без RL. Модель OpenAI должна иметь дополнительную тонкую настройку цепочки рассуждений и извлечение знаний и т.д.». Он также согласен с тем, что дополнительные шаги, такие как предварительное обучение с контролируемой тонкой настройкой, могут улучшить результаты для моделей рассуждений.

Источник

Источник новости: habr.com