«Хайп» вокруг ChatGPT и других генеративных нейросетей от компании OpenAI не мог остаться без внимания NVIDIA. Для запуска языковых моделей компания приготовила особенный GPU-ускоритель H100 NVL. Технически это пара ускорителей H100, соединённых быстрой шиной NVLink (600 ГБ/с), но не всё так просто.

В составе ускорителя H100 у графического процессора GH100 активны только 5 стеков памяти HBM3 из 6. У нового ускорителя активны все. Это обеспечивает не только больше памяти, но и большую пропускную способность: 80 ГБ и 3,35 ТБ/с против 188 ГБ и 7,8 ТБ/с. Вычислительная мощность GPU, очевидно, вдвое больше, чем у H100. Ознакомиться с характеристиками H100 NVL и H100 в модификациях SXM и PCI-E можно в таблице:

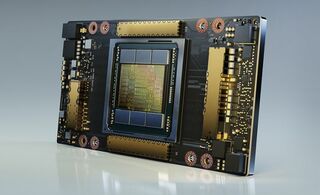

Внешне H100 NVL выглядит как пара H100 и займёт в сервере сразу 4 слота расширения. Судя по разъёмам PCI-E на представленном изображении, каждый из ускорителей вставляется в свой слот.

Новинка поступит в продажу во второй половине этого года. О цене данных нет, но судя по $30 000 за PCI-E версию H100, NVL-модификация обойдётся минимум вдвое дороже.

Источник новости: www.playground.ru