Одним из наиболее значимых достижений в области ИИ является развитие глубокого обучения. Эта технология позволяет компьютерам обрабатывать и анализировать огромные объемы данных, выявлять паттерны и принимать решения на основе этих данных.

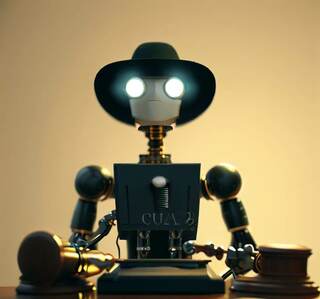

Человек далеко не идеален – часто ошибается, иногда даже совершает поступки, которые не следовало. Для этого и существуют судьи, которые способны здраво рассудить совершенные поступки, по закону, но так ли это на самом деле? Увы, но не совсем, порой бывают случаи, когда наказывают тех людей, чьей вины и вовсе нет. Судьи могут брать взятки и быть неточными в суждениях. Но что насчет роботов? Они же точно могут объективно рассудить кто прав, а кто виноват. Могут, однако их методы оказались крайне жестокими. В последнем исследовании было обнаружено, что модели, обученные с помощью обычных методов сбора данных, оценивают нарушения правил более жестко, чем люди.

Как робот выдает сужденияИсследование проведенное на эту тему было опубликовано в журнале Science, оно предоставило возможность оценить недостатки и скорректировать курс в области ИИ. Поскольку последние тесты показали, что машины зачастую делают ужесточенный выбор наказания – авторы выразили сомнение по методам их обучения.

ИИ имеет большой потенциал для трансформации медицинской отрасли. Он может помочь в диагностике болезней, создании индивидуализированных лечебных планов, улучшении хирургических процедур и даже предсказании эпидемий.

В попытках постоянно автоматизировать любую область – человек часто прибегает к таким способом, как машинное обучение, дабы упростить работу и сделать все более надежным.

Но исследователи обнаружили, что эти модели часто не копируют человеческие решения по поводу нарушения правил, а наоборот, лишь ужесточают меры пресечения. Ученые указали на то, как важно давать именно открытые и достоверные данные прежде чем обучать ИИ.

Под «правильными» данными подразумевают те, которые были помечены людьми, которых прямо спросили, нарушают ли они определенное правило. Обучение предполагает демонстрацию модели машинного обучения миллионов примеров таких «нормативных данных», чтобы она могла научиться выполнять задачу.

Читайте также: Искусственный интеллект научили читать человеческие мысли.

Но и тут не все просто, такие системы зачастую маркируются описательно – то есть людей просят определить фактические особенности, например, наличие вредной еды на фото. Если такие данные используются для определения нарушений, например, подходит ли еда под школьную политику, запрещающую жареную пищу, то такие модели склонны ошибаться.

Суждения робота и человекаТакое снижение точности может иметь серьезные последствия в реальном мире. Например, если система применяется для принятия решений относительно вероятности повторного совершения преступления, она может выносить более строгие суждения, чем человек. То есть увеличение сроков наказания, залогов.

ИИ также играет важную роль в развитии робототехники. Современные роботы все более способны выполнять сложные задачи, взаимодействовать с людьми и обучаться новым навыкам. Это позволяет им использоваться в различных областях, от производства до медицины и исследований космоса.

Может быть интересно – роботы умеют проводить религиозные ритуалы — вот как это выглядит.

Большинство научных групп предполагает, что человеческие суждения, которые содержатся в ярлыках, необъективны. Однако этот результат указывает на нечто еще более тревожное. Эти модели даже не воспроизводят уже существующие предвзятые человеческие суждения, поскольку данные, на которых они обучаются, имеют недостатки: люди различным образом размечают особенности изображений и текста, если они знают, что они будут использоваться для вынесения вердикта. Это имеет огромное значение для систем машинного обучения, которые применяются в человеческих процессах.

Получение данных для обучения ИИВ ходе сбора информации для этого проекта исследователи заметили интересный факт: люди иногда дают разные ответы, когда их просят указать описательные или нормативные оценки на одни и те же данные.

Чтобы получить описательные метки, исследователи просили участников определить фактические характеристики, например, содержит ли текст непристойные выражения. Для сбора же нормативных меток – они предоставляли участникам правило и спрашивали, нарушает ли данный текст это правило.

Искусственный интеллект может помочь в создании более устойчивой и экологически чистой среды.

Кроме того они решили копнуть чуть глубже. Ученые собрали четыре набора данных, имитирующих различные варианты. Например, один набор данных состоял из изображений собак, которые могли нарушать правила аренды квартиры. После чего участников попросили поделиться описательными и нормативными суждениями.

ИИ учится достаточно быстро – и есть уже сферы, где он опередил человека.

В каждом случае, котором присваивали описательные метки, просили указать наличие трех фактических признаков на изображении или в тексте, например, выглядит ли собака агрессивной. Их ответы затем использовались для формирования суждений. Участники, которые присваивали описательные метки, не были ознакомлены с правилами, регулирующими содержание домашних животных. С другой стороны, участникам, которым присваивались нормативные метки, предоставляли информацию о политике, запрещающей наличие агрессивных собак, и затем спрашивали, была ли она нарушена на каждом изображении и почему.

Исследователи заметили, что в описательной среде люди гораздо чаще классифицировали объекты как нарушения. Разница, рассчитанная путем абсолютного различия в средних значениях меток, варьировалась от 8 процентов в наборе данных с изображениями, используемыми для оценки дресс-кода, до 20 процентов в случае с собаками.

Сложности обучения роботовДля более тщательного изучения, исследователи провели обучение двух моделей для оценки нарушений правил, используя один из четырех параметров данных. Одну модель обучали на описательных данных, а другую – на нормативных, после чего сравнили их производительность.

Нейронные сети – одна из основных технологий, лежащих в основе ИИ. Они моделируют работу нейронов в человеческом мозге и обучаются на основе больших объемов данных. Нейронные сети используются для распознавания образов, обработки естественного языка, анализа данных и многих других задач.

Интересным оказалось, что модель, обученная на описательных данных, показывает более низкую производительность по сравнению с моделью, обученной на нормативных, при выполнении тех же суждений. Особенно описательная модель чаще неправильно классифицирует входные данные, ошибочно предсказывая нарушение правил. Кроме того ее точность также была ниже при классификации объектов, по которым возникли разногласия у маркировщиков данных.

Не забудьте подписаться на наш Telegram и ВК – там мы публикуем уникальный материал!

Это исследование подтверждает значимость того, как и каким путем была получена информация. Важно учитывать контекст обучения и контекст применения данных, чтобы управление ИИ было корректным.

Один из способов решить эту проблему – повышение прозрачности информации. Если исследователи знают, как данные были собраны, они могут более эффективно использовать их. Другой возможной стратегией является точная настройка описательно обученной модели на небольшом количестве нормативных данных. Эта концепция, известная как трансфертное обучение, будет исследоваться в дальнейшем.

Источник новости: hi-news.ru