Специалисты из лаборатории исследований искусственного интеллекта (ИИ) T‑Bank AI Research создали новую архитектуру быстрых языковых моделей. Об этом событии в компании рассказали Хабру. Нейросеть сокращает расходы на вычислительные мощности и ускоряет работу с длинным текстом. Разработчики проекта пояснили, что в перспективе это позволит шире применять языковые модели в бизнесе и поможет сократить выбросы парниковых газов за счёт меньшего энергопотребления.

По данным T‑Bank AI Research, информация с описанием новой нейросети была представлена на международной конференции ACL. Научную работу по этому проекту цитировали Принстонский университет и Университет Карнеги — Меллона. Почти все языковые модели в мире используют именно их наработки.

Суть открытия заключается в тои, что самые распространённые языковые модели основаны на архитектуре «Трансформер», представленной в 2017 году исследователями из Google. Они хорошо зарекомендовали себя при решении практических задач, но для них требуется очень большое количество ресурсов, которые растут квадратично с удлинением текста. Для широкого практического применения необходимы менее ресурсозатратные архитектуры.

Наиболее успешные конкуренты трансформеров — последние SSM-модели (State Space Model, модели пространства состояний) Mamba, но они уступают по способности контекстного обучения, которое позволяет ИИ-агентам адаптироваться к новым задачам без необходимости повторного обучения.

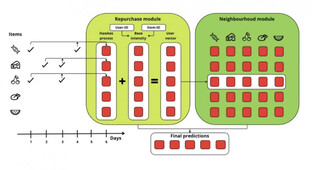

В модели Based, представленной учёными Стэнфорда в декабре 2023 года, которая значительно улучшила способности контекстного обучения, специалисты T-Bank AI Research обнаружили неэффективное использование ресурсов из-за неоптимальной структуры нейросети.

Проведя анализ архитектуры Base, специалисты из T-Bank AI Research оптимизировали механизм извлечения информации из текста, добавив новые обучаемые параметры, которые отвечают за оптимальный поиск взаимосвязей между частями текста. Это решение позволило улучшить процесс его обработки и получать более точные ответы. Эксперты по ИИ также упростили алгоритм выделения текстовой информации, что привело к увеличению производительности, повышению качества работы с длинными текстами и улучшению контекстного обучения. В среднем понимание взаимосвязей в тексте в новой архитектуре стало лучше на 10%.

По данным T-Bank AI Research, ReBased способна снизить издержки на использование искусственного интеллекта для специализированных задач, которые имеют конкретную область применения и требуют учёта её особенностей. Например, в медицине такой задачей может считаться классификация текстов на основе симптомов и диагнозов.

Новая архитектура, предложенная T-Bank AI Research, позволяет приблизить качество линейных моделей к трансформерам. Модели, в основе которых лежит ReBased, могут генерировать тексты с более низкими требованиями к ресурсам практически без потери качества.

Специалисты T-Bank AI Research проводили эксперименты на датасете MQAR (Multi-Query Associative Recall), который позволяет определять способность модели к контекстуальному обучению, а именно к ассоциативному запоминанию (запоминанию не связанных пар объектов), например: лицо человека — его имя.

Подробное описание модели и результаты экспериментов доступны в статье Linear Transformers with Learnable Kernel Functions are Better In-Context Models.

Исходный код проекта и дополнительные материалы по этой теме опубликованы на GitHub.

Ранее специалисты из T‑Bank AI Research и института AIRI разработали модель в области контекстного обучения (In‑Context Learning), которая умеет самостоятельно обучаться новым действиям всего на нескольких примерах.

В конце июля учёные из T-Bank AI Research и института AIRI представили датасет для контекстного обучения с подкреплением XLand-100B. Создатели обещают, что он поможет быстрее и дешевле проводить исследования без привлечения узкопрофильных специалистов и ставить эксперименты на синтетических данных для анализа новых подходов в обучении ИИ.

Источник новости: habr.com