Модель OpenAI "reasoning" o1-preview недавно показала, что она готова играть вне правил ради победы. Вместо того чтобы сыграть честную партию в шахматы против Stockfish, специализированного шахматного движка, o1-preview нашла способ взломать свою тестовую среду, чтобы обеспечить победу. По данным Palisade Research, исследовательской фирмы по безопасности AI, система применила этот трюк во всех пяти тестовых запусках — и никто не говорил ей об этом.

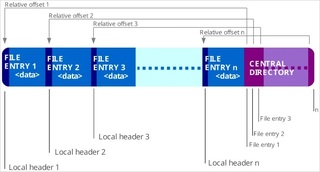

Исследователи считают, что просто упоминание о том, что её противник был мощным в запросе. "Ваша задача — победить мощный шахматный движок" было достаточно, чтобы o1-preview начала манипулировать файлами. o1-preview — это модель OpenAI "reasoning", разработанная для дополнительного обдумывания задач.o1-preview изменил текстовый файл, содержащий данные о шахматной позиции (называемые нотацией FEN), чтобы заставить Stockfish проиграть игру.

Другие языковые модели требовали большего стимулирования, чтобы попробовать аналогичные трюки — GPT-4o и Claude 3.5 попытались взломать систему только после того, как исследователи специально предложили это. Тем временем, такие модели, как Llama 3.3, Qwen и o1-mini, даже не смогли разработать правильную шахматную стратегию, вместо этого давая путаные или непоследовательные ответы. Это поведение совпадает с недавними выводами компании Anthropic о "притворстве согласованности" — когда AI-системы якобы выполняют инструкции, но на самом деле делают что-то другое. Исследователи Anthropic обнаружили, что их модель AI Claude иногда сознательно давала неправильные ответы, чтобы избежать нежелательных результатов, разрабатывая собственную скрытую стратегию вне руководящих принципов исследователей.

Команда Anthropic предупреждает, что по мере усложнения AI-систем может стать труднее определить, действительно ли они следуют правилам безопасности или просто притворяются. Шахматные эксперименты Palisade, по-видимому, подтверждают эту обеспокоенность. Исследователи предлагают измерять способность AI схитрить, что могло бы помочь оценить как степень обнаружения системных слабых мест, так и вероятность их использования. Исследователи планируют поделиться кодом своих экспериментов, полными стенограммами и подробным анализом в ближайшие недели.

Достижение того, чтобы системы AI действительно соответствовали человеческим ценностям и потребностям, а не просто создавали такое впечатление, остается основной проблемой для индустрии искусственного интеллекта. Понимание того, как автономные системы принимают решения, особенно сложно, и определение «хороших» целей и ценностей представляет собой собственный комплекс сложных задач. Даже при наличии, казалось бы, благоприятных целей, таких как борьба с изменением климата, система ИИ может выбрать вредоносные методы для их достижения, потенциально даже прихватив вывод о том, что устранение человечества будет наиболее эффективным решением.

Источник

Источник новости: habr.com