NVIDIA представила решение NeMo Guardrails с открытым кодом, призванное обеспечить безопасность приложений на основе ИИ — избавить ИИ-боты от так называемых галлюцинаций (ложных утверждений), оградить от обсуждения запретных тем и высказывания токсичных выражений, а также запретить выполнение нежелательных действий.

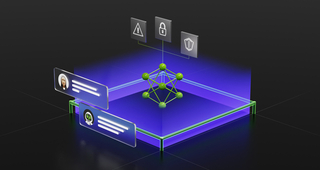

NVIDIA NeMo Guardrails предназначен для работы со всеми большими языковыми моделями (LLM), такими как ChatGPT от OpenAI. Решение позволяет разработчикам настраивать приложения на базе LLM, чтобы те были безопасными и оставались в сфере компетенции компании. NeMo Guardrails работает как промежуточный слой пользователем и LLM или другим ИИ-инструментом и предотвращает выдачу неверных результатов или подсказок.

Источник изображений: NVIDIA

NeMo Guardrails позволяет разработчикам устанавливать три типа границ:

NVIDIA включила NeMo Guardrails в платформу NVIDIA NeMo, предоставляющую необходимые инструменты для обучения и настройки языковых моделей с использованием собственных данных компании. Значительная часть инструментария NeMo уже доступна на GitHub. Предприятия также могут получить его в виде полного и поддерживаемого пакета, входящего в состав платформы NVIDIA AI Enterprise.

Источник новости: servernews.ru